寵物貓在廚房搗亂,小哥用Google AIY視覺紙盒監控它!

有人說,"當代人的最新炫富模式是——你有貓嗎?"的確,喵星人的治癒係數在某些程度上,甚至已經蓋過了美食。人類在這個"弱小"的萌物面前,也心甘情願地俯首稱臣。

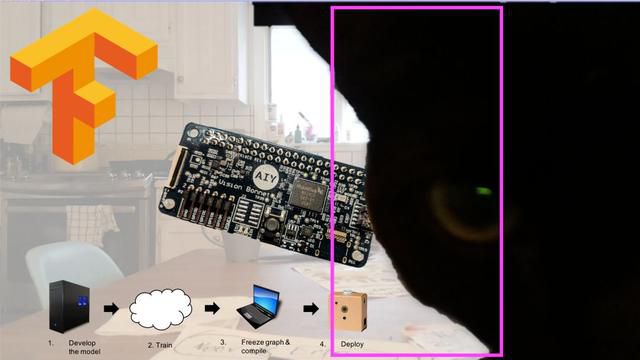

國外有個碼農小哥,因為自家的喵主人在廚房屢屢"犯案",所以他靈機一動,發揮自己聰明的小腦殼,利用 Google 的 AIY Vision Kit 做了一個喵星人追蹤器,將自己的貓從廚房趕走。

國外有個碼農小哥,因為自家的喵主人在廚房屢屢"犯案",所以他靈機一動,發揮自己聰明的小腦殼,利用 Google 的 AIY Vision Kit 做了一個喵星人追蹤器,將自己的貓從廚房趕走。

犯案現場,嫌疑犯並不打算認罪

讓我們一起來看看這位小哥的心路歷程和傑作。

簡單介紹下 AIY Vision Kit

AIY Vision Kit,是 Google 推出的一款簡單的電腦視覺系統產品,也是Google AIY Projects 旗下的第二款產品(第一款產品是 Voice Kit,是一款基於樹莓派的人工智慧語音套件)。

它是一個 DIY 人工智慧套件,用戶可以自己動手,打造好玩有趣的 AI 創意作品(比如智能相機之類的)。

01/配置

Vision Kit 是一個由硬紙板拼裝起來的小紙盒組成。主要核心硬體包括一個 Raspberry Pi Zero WH、一個Vision Bonnet 電路板、一個Micro SD卡,以及攝像頭等等組件。

組件

可別小瞧這個小紙盒——"小身板,大能量",這個紙盒可以處理圖像識別和電腦視覺功能, 支持離線識別上千種常見物體(動物、植物)以及檢測人臉、面部表情等。

尤其是內置的 Vision Bonnet,採用了 Intel Movidius MA 2450 處理器,它可以強化 Raspberry Pi Zero WH 的視覺處理。此外,Google 也為 Vision Kit 提供了基於 TensorFlow 的類神經網路模型。

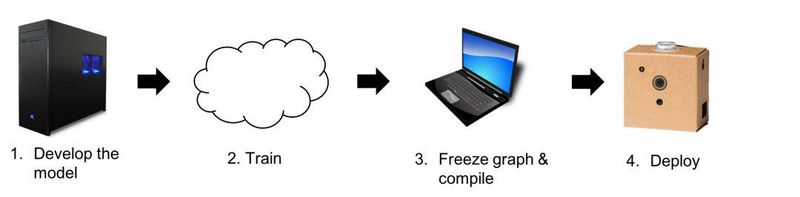

02/模型

AIY Vision Kit 自帶多個模型,比如人臉檢測、表情分析、食物檢測等等。大多數是圖像分類模型:(如圖)

值得一提的是,Vision Kit 含有一個"狗/貓/人"的物體檢測模型。而這位小哥也剛好利用這一模型,檢測喵主子在廚房"胡作非為"。

過程

當然一開始並不是很順利,可能是自家的喵太黑了(令人髮指的黑),加上廚房的光線不足。利用盒子自帶的模型,識別的情況讓小哥不太滿意。

於是小哥的小腦殼又開始轉動了:自己動手、豐衣足食——為什麼不用 TensorFlow 自定義訓練模型呢?!(想想還有點小激動~~)

Vision Kit 靈活的拓展空間和小哥飽滿的 DIY 熱情完美地契合在一起...

訓練模型

這位小哥在動手的同時,也積極地和網友們分享他嘔心瀝血提煉出來的一些訓練技巧。

1.收集訓練圖像。

小哥為它心愛的喵主子大概拍攝了幾百張圖片,完美涵蓋喵主子在現實世界中的不同場景(尤其是廚房)、不同光照條件、各種角度的照片。

2.手動標記每張圖像。

3.準備訓練數據集

將標籤轉換為適當的格式,製作標籤映射檔,並將圖像分成大型訓練集和較小的評估集。

4.在對象檢測配置檔中設置正確的參數。

5.準備 TensorFlow 環境。

6.訓練並生成模型。

7.將模型固化。

8.在 Ubuntu 中使用 Bonnet Compiler 編譯模型。

9.將編譯後的模型加載到 Vision Kit 上。

10.調整示例代碼以使其與編譯模型一起工作。

11.運行模型代碼,見證奇跡的時刻。

大家也可以在小哥的 Github 上查看具體代碼。

經過一段"漫長又曲折"的過程,喵主子專屬的識別追蹤"神器"終於打造成功了!

小哥將 Vision Kit 放在廚房,當盒子識別到喵主子的時候,會發出"嗶嗶"的聲音。這樣一來,有助於將貓嚇走,防止它在廚房搗亂。

不過後來小哥發現,時間久了,他淘氣的喵主子已經不再害怕盒子發出的"嗶嗶"聲了…..(笑哭)

於是小哥打算再搗鼓接入一個機器人,讓盒子識別到喵主子的時候,機器人能根據座標,向貓貓發射小彈珠….

為了從廚房趕走喵主子,這位小哥也是心累…如果讀者朋友也有這樣的煩惱,不妨試一試這位小哥的做法。讓我們祝小哥好運並期待他的新作品吧。

Google AIY 套件正式抵港,語音版本Voice Kit,視覺版本Vision Kit 線上發售。自己動手做AI人工智慧開發,讓初學者接觸人工智能圖像辨識、語言支援技術。以紙板為外殻的小工具,可以辨識物件、當作 Google Home 來控制家電等,另外自行編寫不同的程式,有著更多元化的創作方向。https://store.gravitylink.com

Comments

Post a Comment